Sonntag, 3. April 2011

Sensationelle Papstaussage im neuen Buch

klauslange,22:21h

Am 31.März beendete ich die Lektüre des neuen Papstbuches zu Jesus von Nazareth - Band II -. Darin macht Benedikt XVI. eine sensationelle Aussage, die sich genau mit dem beschäftigt und stützt, was auch Michael König in seinem Urwort - Buch herausstellt.

Damit dies niemand für einen Aprilscherz hält, habe ich bis heute mit meiner Vorankündigung gewartet:

Ich werde demnächst im Blog 'Evolution und Schöpfung' ausführlich auf diese Passage eingehen und deren wissenschaftliche Bedeutung im Lichte der Urwort - Theorie erörtern.

Dazu braucht es aber eine gewisse Zeit, daher heute nur ersteinmal diese Vorwarnung.

Übrigens hat m.W. bis heute diese gefundene Passage noch niemand herausgestellt. Ich denke, um ihren sensationellen Gehalt erkennen zu können, muss man Michael Königs Buch verinnerlicht haben. Leider scheint es mir so, dass die Schnittmenge der Leser von König und der Leser vom neuen Papstbuch recht gering ist. Später mehr dazu: Stay tuned...!

Damit dies niemand für einen Aprilscherz hält, habe ich bis heute mit meiner Vorankündigung gewartet:

Ich werde demnächst im Blog 'Evolution und Schöpfung' ausführlich auf diese Passage eingehen und deren wissenschaftliche Bedeutung im Lichte der Urwort - Theorie erörtern.

Dazu braucht es aber eine gewisse Zeit, daher heute nur ersteinmal diese Vorwarnung.

Übrigens hat m.W. bis heute diese gefundene Passage noch niemand herausgestellt. Ich denke, um ihren sensationellen Gehalt erkennen zu können, muss man Michael Königs Buch verinnerlicht haben. Leider scheint es mir so, dass die Schnittmenge der Leser von König und der Leser vom neuen Papstbuch recht gering ist. Später mehr dazu: Stay tuned...!

... link (3 Kommentare) ... comment

Samstag, 2. April 2011

Ausführliches Interview mit Dr. Michael König

klauslange,18:19h

... link (0 Kommentare) ... comment

Montag, 21. März 2011

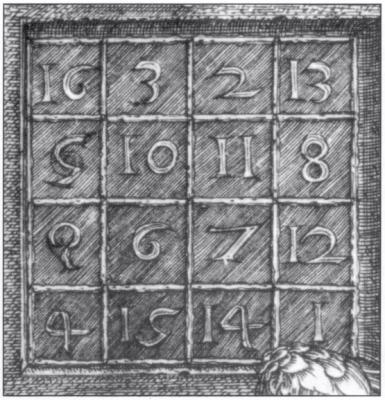

Raum als Schachbrettmuster?

klauslange,21:02h

Wie kann man sich den dreidimensionalen Raum vorstellen? Existiert er an und für sich? Ein interessantes Model haben zwei Forscher nun entwickelt.

sciencedaily berichtet hier.

While studying graphene's electronic properties, professor Chris Regan and graduate student Matthew Mecklenburg found that a particle can acquire spin by living in a space with two types of positions -- dark tiles and light tiles. The particle seems to spin if the tiles are so close together that their separation cannot be detected.

"An electron's spin might arise because space at very small distances is not smooth, but rather segmented, like a chessboard," Regan said.

Their findings are published in the March 18 edition of the journal Physical Review Letters.

In quantum mechanics, "spin up" and "spin down" refer to the two types of states that can be assigned to an electron. That the electron's spin can have only two values -- not one, three or an infinite number -- helps explain the stability of matter, the nature of the chemical bond and many other fundamental phenomena.

However, it is not clear how the electron manages the rotational motion implied by its spin. If the electron had a radius, the implied surface would have to be moving faster than the speed of light, violating the theory of relativity. And experiments show that the electron does not have a radius; it is thought to be a pure point particle with no surface or substructure that could possibly spin.

In 1928, British physicist Paul Dirac showed that the spin of the electron is intimately related to the structure of space-time. His elegant argument combined quantum mechanics with special relativity, Einstein's theory of space-time (famously represented by the equation E=mc2).

Dirac's equation, far from merely accommodating spin, actually demands it. But while showing that relativistic quantum mechanics requires spin, the equation does not give a mechanical picture explaining how a point particle manages to carry angular momentum, nor why this spin is two-valued.

Unveiling a concept that is at once novel and deceptively simple, Regan and Mecklenburg found that electrons' two-valued spin can arise from having two types of tiles -- light and dark -- in a chessboard-like space. And they developed this quantum mechanical model while working on the surprisingly practical problem of how to make better transistors out of a new material called graphene.

Graphene, a single sheet of graphite, is an atomically-thin layer of carbon atoms arranged in a honeycomb structure. First isolated in 2004 by Andre Geim and Kostya Novoselov, graphene has a wealth of extraordinary electronic properties, such as high electron mobility and current capacity. In fact, these properties hold such promise for revolutionary advances that Geim and Novoselov were awarded the 2010 Nobel Prize a mere six years after their achievement.

Regan and Mecklenburg are part of a UCLA effort to develop extremely fast transistors using this new material.

"We wanted to calculate the amplification of a graphene transistor," Mecklenburg said. "Our collaboration was building them and needed to know how well they were going to work."

This calculation involved understanding how light interacts with the electrons in graphene.

The electrons in graphene move by hopping from carbon atom to carbon atom, as if hopping on a chessboard. The graphene chessboard tiles are triangular, with the dark tiles pointing "up" and light ones pointing "down." When an electron in graphene absorbs a photon, it hops from light tiles to dark ones. Mecklenburg and Regan showed that this transition is equivalent to flipping a spin from "up" to "down."

In other words, confining the electrons in graphene to specific, discrete positions in space gives them spin. This spin, which derives from the special geometry of graphene's honeycomb lattice, is in addition to and distinct from the usual spin carried by the electron. In graphene the additional spin reflects the unresolved chessboard-like structure to the space that the electron occupies.

sciencedaily berichtet hier.

While studying graphene's electronic properties, professor Chris Regan and graduate student Matthew Mecklenburg found that a particle can acquire spin by living in a space with two types of positions -- dark tiles and light tiles. The particle seems to spin if the tiles are so close together that their separation cannot be detected.

"An electron's spin might arise because space at very small distances is not smooth, but rather segmented, like a chessboard," Regan said.

Their findings are published in the March 18 edition of the journal Physical Review Letters.

In quantum mechanics, "spin up" and "spin down" refer to the two types of states that can be assigned to an electron. That the electron's spin can have only two values -- not one, three or an infinite number -- helps explain the stability of matter, the nature of the chemical bond and many other fundamental phenomena.

However, it is not clear how the electron manages the rotational motion implied by its spin. If the electron had a radius, the implied surface would have to be moving faster than the speed of light, violating the theory of relativity. And experiments show that the electron does not have a radius; it is thought to be a pure point particle with no surface or substructure that could possibly spin.

In 1928, British physicist Paul Dirac showed that the spin of the electron is intimately related to the structure of space-time. His elegant argument combined quantum mechanics with special relativity, Einstein's theory of space-time (famously represented by the equation E=mc2).

Dirac's equation, far from merely accommodating spin, actually demands it. But while showing that relativistic quantum mechanics requires spin, the equation does not give a mechanical picture explaining how a point particle manages to carry angular momentum, nor why this spin is two-valued.

Unveiling a concept that is at once novel and deceptively simple, Regan and Mecklenburg found that electrons' two-valued spin can arise from having two types of tiles -- light and dark -- in a chessboard-like space. And they developed this quantum mechanical model while working on the surprisingly practical problem of how to make better transistors out of a new material called graphene.

Graphene, a single sheet of graphite, is an atomically-thin layer of carbon atoms arranged in a honeycomb structure. First isolated in 2004 by Andre Geim and Kostya Novoselov, graphene has a wealth of extraordinary electronic properties, such as high electron mobility and current capacity. In fact, these properties hold such promise for revolutionary advances that Geim and Novoselov were awarded the 2010 Nobel Prize a mere six years after their achievement.

Regan and Mecklenburg are part of a UCLA effort to develop extremely fast transistors using this new material.

"We wanted to calculate the amplification of a graphene transistor," Mecklenburg said. "Our collaboration was building them and needed to know how well they were going to work."

This calculation involved understanding how light interacts with the electrons in graphene.

The electrons in graphene move by hopping from carbon atom to carbon atom, as if hopping on a chessboard. The graphene chessboard tiles are triangular, with the dark tiles pointing "up" and light ones pointing "down." When an electron in graphene absorbs a photon, it hops from light tiles to dark ones. Mecklenburg and Regan showed that this transition is equivalent to flipping a spin from "up" to "down."

In other words, confining the electrons in graphene to specific, discrete positions in space gives them spin. This spin, which derives from the special geometry of graphene's honeycomb lattice, is in addition to and distinct from the usual spin carried by the electron. In graphene the additional spin reflects the unresolved chessboard-like structure to the space that the electron occupies.

... link (0 Kommentare) ... comment

Sonntag, 20. März 2011

Meine Abhandlung zur Urwort - Theorie

klauslange,14:29h

Habe eine Abhandlung zur Urwort - Theorie (siehe auch meine Buchbesprechung hier) verfasst, die zeigt, dass anhand des Dimensionsgesetzes von Heim und Dröscher zu sehen ist, dass die Urwort - Theorie die übergeordnete Theorie ist. Mir ist mit der Topologie der Urwort - Matrix gelungen die Bedeutung aller möglichen Zahlenpaare des Dimensionsgesetzes herzuleiten, auch {57; 420}.

Zu finden ist meine Abhandlung auf der Datenbank von 'Borderlands of Science' (scrollen bis mein Name erscheint): hier

Meines Wissens ist diese Abhandlung die erste Herleitung aus der Urwort - Theorie, die nicht durch Dr. König selbst erzielt wurde. In einer email-Korrespondenz habe ich Herrn Dr. König vorab die Abhandlung geschickt und er ermutigte mich hocherfreut, diese zu veröffentlichen.

Die Start-Seite von Borderlands of Science habe ich auch in meine Linkliste aufgenommen.

Zu finden ist meine Abhandlung auf der Datenbank von 'Borderlands of Science' (scrollen bis mein Name erscheint): hier

Meines Wissens ist diese Abhandlung die erste Herleitung aus der Urwort - Theorie, die nicht durch Dr. König selbst erzielt wurde. In einer email-Korrespondenz habe ich Herrn Dr. König vorab die Abhandlung geschickt und er ermutigte mich hocherfreut, diese zu veröffentlichen.

Die Start-Seite von Borderlands of Science habe ich auch in meine Linkliste aufgenommen.

... link (0 Kommentare) ... comment

Mittwoch, 16. März 2011

LHC: Erste Zeitmaschine?

klauslange,23:21h

Eine interessante Theorie wird in sciencedaily.com vorgestellt, die eine Art von Zeitmaschine für Materieteilchen durch das LHC beschreibt:

hier

One of the major goals of the collider is to find the elusive Higgs boson: the particle that physicists invoke to explain why particles like protons, neutrons and electrons have mass. If the collider succeeds in producing the Higgs boson, some scientists predict that it will create a second particle, called the Higgs singlet, at the same time.

According to Weiler and Ho's theory, these singlets should have the ability to jump into an extra, fifth dimension where they can move either forward or backward in time and reappear in the future or past.

"One of the attractive things about this approach to time travel is that it avoids all the big paradoxes," Weiler said. "Because time travel is limited to these special particles, it is not possible for a man to travel back in time and murder one of his parents before he himself is born, for example. However, if scientists could control the production of Higgs singlets, they might be able to send messages to the past or future."

Unsticking the "brane"

The test of the researchers' theory will be whether the physicists monitoring the collider begin seeing Higgs singlet particles and their decay products spontaneously appearing. If they do, Weiler and Ho believe that they will have been produced by particles that travel back in time to appear before the collisions that produced them.

Weiler and Ho's theory is based on M-theory, a "theory of everything." A small cadre of theoretical physicists have developed M-theory to the point that it can accommodate the properties of all the known subatomic particles and forces, including gravity, but it requires 10 or 11 dimensions instead of our familiar four. This has led to the suggestion that our universe may be like a four-dimensional membrane or "brane" floating in a multi-dimensional space-time called the "bulk."

According to this view, the basic building blocks of our universe are permanently stuck to the brane and so cannot travel in other dimensions. There are some exceptions, however. Some argue that gravity, for example, is weaker than other fundamental forces because it diffuses into other dimensions. Another possible exception is the proposed Higgs singlet, which responds to gravity but not to any of the other basic forces.

Answers in neutrinos?

Weiler began looking at time travel six years ago to explain anomalies that had been observed in several experiments with neutrinos. Neutrinos are nicknamed ghost particles because they react so rarely with ordinary matter: Trillions of neutrinos hit our bodies every second, yet we don't notice them because they zip through without affecting us.

Weiler and colleagues Heinrich Päs and Sandip Pakvasa at the University of Hawaii came up with an explanation of the anomalies based on the existence of a hypothetical particle called the sterile neutrino. In theory, sterile neutrinos are even less detectable than regular neutrinos because they interact only with gravitational force. As a result, sterile neutrinos are another particle that is not attached to the brane and so should be capable of traveling through extra dimensions.

Weiler, Päs and Pakvasa proposed that sterile neutrinos travel faster than light by taking shortcuts through extra dimensions. According to Einstein's general theory of relativity, there are certain conditions where traveling faster than the speed of light is equivalent to traveling backward in time. This led the physicists into the speculative realm of time travel.

hier

One of the major goals of the collider is to find the elusive Higgs boson: the particle that physicists invoke to explain why particles like protons, neutrons and electrons have mass. If the collider succeeds in producing the Higgs boson, some scientists predict that it will create a second particle, called the Higgs singlet, at the same time.

According to Weiler and Ho's theory, these singlets should have the ability to jump into an extra, fifth dimension where they can move either forward or backward in time and reappear in the future or past.

"One of the attractive things about this approach to time travel is that it avoids all the big paradoxes," Weiler said. "Because time travel is limited to these special particles, it is not possible for a man to travel back in time and murder one of his parents before he himself is born, for example. However, if scientists could control the production of Higgs singlets, they might be able to send messages to the past or future."

Unsticking the "brane"

The test of the researchers' theory will be whether the physicists monitoring the collider begin seeing Higgs singlet particles and their decay products spontaneously appearing. If they do, Weiler and Ho believe that they will have been produced by particles that travel back in time to appear before the collisions that produced them.

Weiler and Ho's theory is based on M-theory, a "theory of everything." A small cadre of theoretical physicists have developed M-theory to the point that it can accommodate the properties of all the known subatomic particles and forces, including gravity, but it requires 10 or 11 dimensions instead of our familiar four. This has led to the suggestion that our universe may be like a four-dimensional membrane or "brane" floating in a multi-dimensional space-time called the "bulk."

According to this view, the basic building blocks of our universe are permanently stuck to the brane and so cannot travel in other dimensions. There are some exceptions, however. Some argue that gravity, for example, is weaker than other fundamental forces because it diffuses into other dimensions. Another possible exception is the proposed Higgs singlet, which responds to gravity but not to any of the other basic forces.

Answers in neutrinos?

Weiler began looking at time travel six years ago to explain anomalies that had been observed in several experiments with neutrinos. Neutrinos are nicknamed ghost particles because they react so rarely with ordinary matter: Trillions of neutrinos hit our bodies every second, yet we don't notice them because they zip through without affecting us.

Weiler and colleagues Heinrich Päs and Sandip Pakvasa at the University of Hawaii came up with an explanation of the anomalies based on the existence of a hypothetical particle called the sterile neutrino. In theory, sterile neutrinos are even less detectable than regular neutrinos because they interact only with gravitational force. As a result, sterile neutrinos are another particle that is not attached to the brane and so should be capable of traveling through extra dimensions.

Weiler, Päs and Pakvasa proposed that sterile neutrinos travel faster than light by taking shortcuts through extra dimensions. According to Einstein's general theory of relativity, there are certain conditions where traveling faster than the speed of light is equivalent to traveling backward in time. This led the physicists into the speculative realm of time travel.

... link (0 Kommentare) ... comment

Mittwoch, 16. März 2011

Eine Alternative zur Dunklen Energie widerlegt

klauslange,00:23h

Eine interessante Alternative zur Dunklen Energie konnte nun widerlegt werden, wie science daily berichtet: hier

... link (0 Kommentare) ... comment

Donnerstag, 3. März 2011

Schwarzes Loch als Elektronenmodell

klauslange,21:55h

In einer interessanten Arbeit benutzen Forscher das Modell von Schwarzen Löchern mit Ladung, um die Interaktionen von Elektronen in einem Supraleiter berechnen zu können, was auch erfolgreich gelang. Auch wenn hier Formalismen der Stringtheorie benutzt wurde, zeigt doch dieser Erfolg, dass die Grundlage der Urwort - Theorie bestätigt wurde. In der UT wird das Elektron als eine Art Schwarzes Loch moduliert, das seine umgebende Raumzeit krümmt.

Der Link zum science daily Artikel hier

Darin

Fourteen years ago, a string theorist, Juan Maldacena, conjectured that some strongly interacting quantum mechanical systems could be modeled by classical gravity in a spacetime having constant negative curvature. The charges in the quantum system are replaced by a charged black hole in the curved spacetime, thereby wedding the geometry of spacetime with quantum mechanics.

Since the Mott problem is an example of strongly interacting particles, Phillips and colleagues asked the question: "Is it possible to devise a theory of gravity that mimics a Mott insulator?" Indeed it is, as they have shown.

The researchers built on Maldacena's mapping and devised a model for electrons moving in a curved spacetime in the presence of a charged black hole that captures two of the striking features of the normal state of high-temperature superconductors: 1) the presence of a barrier for electron motion in the Mott state, and 2) the strange metal regime in which the electrical resistivity scales as a linear function of temperature, as opposed to the quadratic dependence exhibited by standard metals.

The treatment advanced in the paper published in Physical Review Letters shows surprisingly that the boundary of the spacetime consisting of a charged black hole and weakly interacting electrons exhibits a barrier for electrons moving in that region, just as in the Mott state. This work represents the first time the Mott problem has been solved (essentially exactly) in a two-dimensional system, the relevant dimension for the high-temperature superconductors.

Der Link zum science daily Artikel hier

Darin

Fourteen years ago, a string theorist, Juan Maldacena, conjectured that some strongly interacting quantum mechanical systems could be modeled by classical gravity in a spacetime having constant negative curvature. The charges in the quantum system are replaced by a charged black hole in the curved spacetime, thereby wedding the geometry of spacetime with quantum mechanics.

Since the Mott problem is an example of strongly interacting particles, Phillips and colleagues asked the question: "Is it possible to devise a theory of gravity that mimics a Mott insulator?" Indeed it is, as they have shown.

The researchers built on Maldacena's mapping and devised a model for electrons moving in a curved spacetime in the presence of a charged black hole that captures two of the striking features of the normal state of high-temperature superconductors: 1) the presence of a barrier for electron motion in the Mott state, and 2) the strange metal regime in which the electrical resistivity scales as a linear function of temperature, as opposed to the quadratic dependence exhibited by standard metals.

The treatment advanced in the paper published in Physical Review Letters shows surprisingly that the boundary of the spacetime consisting of a charged black hole and weakly interacting electrons exhibits a barrier for electrons moving in that region, just as in the Mott state. This work represents the first time the Mott problem has been solved (essentially exactly) in a two-dimensional system, the relevant dimension for the high-temperature superconductors.

... link (0 Kommentare) ... comment

Freitag, 4. Februar 2011

Vorlesung zur String-Twistoren-Revolution

klauslange,23:52h

Ein sehr interessantes Video einer Vorlesung zur String-Twistoren-Revolution findet sich hier:

http://streamer.perimeterinstitute.ca/mediasite/viewer/NoPopupRedirector.aspx?peid=ff8f97a4-2848-4b93-98d9-1218de2070af&shouldResize=False

http://streamer.perimeterinstitute.ca/mediasite/viewer/NoPopupRedirector.aspx?peid=ff8f97a4-2848-4b93-98d9-1218de2070af&shouldResize=False

... link (0 Kommentare) ... comment

Dienstag, 1. Februar 2011

LHC läuft auch 2012

klauslange,21:30h

Bislang wurde geplant das LHC im Jahre 2012 ruhen zu lassen, um neue Konfigurationen vorzunehmen, die höhere Energien ermöglichen. Aufgrund vielversprechender Messergebnisse wird das LHC aber über Ende 2011 auch 2012 laufen und erst danach eine längere Pause einlegen:

http://www.weltderphysik.de/de/4293.php?ni=2414

http://www.weltderphysik.de/de/4293.php?ni=2414

... link (0 Kommentare) ... comment

Samstag, 8. Januar 2011

Gammastrahlenausbrüche sprengen Theorie

klauslange,17:01h

Diese reißerische Überschrift kommt nicht etwa von mir, sondern gebraucht als Kurzbeschreibung scinexx:

http://www.g-o.de/wissen-aktuell-12799-2011-01-07.html

Zitat:

Dramatische Gammastrahlenausbrüche im Nebel sprengen astrophysikalische Grundannahmen

Bisher galt die Strahlung des Krebsnebels, eines Supernova-Relikts, als so konstant, dass sie als Referenzwert diente. Doch jetzt berichten Astrophysiker in „Science“ von gleich mehreren dramatischen Gammastrahlenausbrüchen im Krebsnebel – die Standardkerze flackert. Und dies mit einer so hohen Intensität, dass alle bisherigen Modelle der kosmischen Teilchenbeschleunigung sie nicht erklären können...

Pulsar ist nicht die Strahlenquelle

Woher aber stammt diese Strahlung? Seltsamerweise gab es während dieser beiden Ausbrüche keinerlei Anzeichen für Veränderungen am Kerbnebelpulsar – eigentlich der naheliegenden Quelle so gewaltiger Energiemengen. Die dramatischen Gammastrahlenausbrüche erreichen Stärken im Gigaelektronenvolt-Bereich. Eine Gammastrahlenintensität in dieser Größenordnung bedeutet aber, dass die zugrundeliegenden Elektronen und Positronen bei den typischen Magnetfeldstärken im Krebsnebels mindestens auf Petaelektronenvolt-Energie beschleunigt worden sein müssen. Dies ist ein neuer Superlativ – es sind damit die höchstenergetischen geladenen Teilchen, die mit einem bekannten astronomischen Objekt in Beziehung gebracht werden können.

Energieintensität sprengt sämtliche Modelle

Doch genau diese Energieintensität ist das Rätselhafte: da der Pulsar nicht die Quelle zu sein scheint, müssen die Gammastrahlen aus dem Nebel selbst stammen. Da die beobachteten Intensitätsschwankungen innerhalb von nur wenigen Tagen stattfanden, vermuten die Astrophysiker, dass die Energie dabei aus einem verhältnismäßig kleinen Gebiet im Krebsnebel stammen muss. Die bislang bekannten Mechanismen können diesen Prozess jedoch nicht erklären.

„Unsere Vorstellungen, wie ein derart immenser Energiegewinn in solch kleinen Gebieten realisiert werden können, müssen jetzt neu hinterfragt werden“, erklärt Olaf Reimer Astrophysiker der Universität Innsbruck und Forscher in der Fermi Large Area Telescope (LAT) Kollaboration. „Die Zeitskalen der Strahlungsausbrüche sind dergestalt, dass die Elektronen einfach nicht genug Zeit hatten, auf ihrer Bewegung entlang der Magnetfeldlinien zu derartigen Energien beschleunigt zu werden.“

Ende einer Epoche

Nach diesen Beobachtungen steht in jedem Fall fest, dass der Krebsnebel, die erste Quelle, die einst am Himmel im Lichte der energiereichsten Gammastrahlung entdeckt wurde, nicht mehr vorbehaltlos als Referenz genutzt werden kann. Wenn solche Standardkerzen flackern, deutet sich das Ende einer Epoche an. Offenbar gibt es in der Erforschung der Hochenergiephänomene am Himmel mehr Lücken, als bisher angenommen.

Kommentar:

Also wissenschaftlich fängt das Jahr wirklich gut an...

http://www.g-o.de/wissen-aktuell-12799-2011-01-07.html

Zitat:

Dramatische Gammastrahlenausbrüche im Nebel sprengen astrophysikalische Grundannahmen

Bisher galt die Strahlung des Krebsnebels, eines Supernova-Relikts, als so konstant, dass sie als Referenzwert diente. Doch jetzt berichten Astrophysiker in „Science“ von gleich mehreren dramatischen Gammastrahlenausbrüchen im Krebsnebel – die Standardkerze flackert. Und dies mit einer so hohen Intensität, dass alle bisherigen Modelle der kosmischen Teilchenbeschleunigung sie nicht erklären können...

Pulsar ist nicht die Strahlenquelle

Woher aber stammt diese Strahlung? Seltsamerweise gab es während dieser beiden Ausbrüche keinerlei Anzeichen für Veränderungen am Kerbnebelpulsar – eigentlich der naheliegenden Quelle so gewaltiger Energiemengen. Die dramatischen Gammastrahlenausbrüche erreichen Stärken im Gigaelektronenvolt-Bereich. Eine Gammastrahlenintensität in dieser Größenordnung bedeutet aber, dass die zugrundeliegenden Elektronen und Positronen bei den typischen Magnetfeldstärken im Krebsnebels mindestens auf Petaelektronenvolt-Energie beschleunigt worden sein müssen. Dies ist ein neuer Superlativ – es sind damit die höchstenergetischen geladenen Teilchen, die mit einem bekannten astronomischen Objekt in Beziehung gebracht werden können.

Energieintensität sprengt sämtliche Modelle

Doch genau diese Energieintensität ist das Rätselhafte: da der Pulsar nicht die Quelle zu sein scheint, müssen die Gammastrahlen aus dem Nebel selbst stammen. Da die beobachteten Intensitätsschwankungen innerhalb von nur wenigen Tagen stattfanden, vermuten die Astrophysiker, dass die Energie dabei aus einem verhältnismäßig kleinen Gebiet im Krebsnebel stammen muss. Die bislang bekannten Mechanismen können diesen Prozess jedoch nicht erklären.

„Unsere Vorstellungen, wie ein derart immenser Energiegewinn in solch kleinen Gebieten realisiert werden können, müssen jetzt neu hinterfragt werden“, erklärt Olaf Reimer Astrophysiker der Universität Innsbruck und Forscher in der Fermi Large Area Telescope (LAT) Kollaboration. „Die Zeitskalen der Strahlungsausbrüche sind dergestalt, dass die Elektronen einfach nicht genug Zeit hatten, auf ihrer Bewegung entlang der Magnetfeldlinien zu derartigen Energien beschleunigt zu werden.“

Ende einer Epoche

Nach diesen Beobachtungen steht in jedem Fall fest, dass der Krebsnebel, die erste Quelle, die einst am Himmel im Lichte der energiereichsten Gammastrahlung entdeckt wurde, nicht mehr vorbehaltlos als Referenz genutzt werden kann. Wenn solche Standardkerzen flackern, deutet sich das Ende einer Epoche an. Offenbar gibt es in der Erforschung der Hochenergiephänomene am Himmel mehr Lücken, als bisher angenommen.

Kommentar:

Also wissenschaftlich fängt das Jahr wirklich gut an...

... link (0 Kommentare) ... comment

... nächste Seite